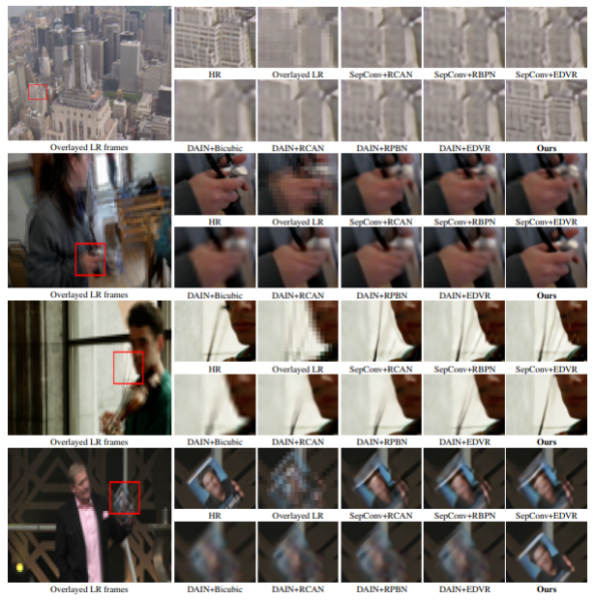

研究人员越来越多地使用AI将历史镜头转换为高分辨率、高帧率的视频,看起来就像是用现代设备拍摄。为了简化该过程,罗切斯特大学、东北大学和普渡大学的研究人员最近提出了一种框架,该框架可从低帧频、低分辨率视频生成高分辨率慢动作视频。

据研究团队表示,他们使用的“时空视频超分辨率(STVSR)”算法不仅在图像质量上比现有方法更好,而且比以前的最新AI模型快三倍。

就某种意义上而言,这一框架的提出是继英伟达在2018年发布的针对视频处理AI模型后的再次提升,当年英伟达的AI模型可以对任何视频应用进行慢动作处理。据了解,类似的高分辨率技术已经应用于视频游戏领域。去年,《最终幻想》的用户通过使用一款名为AI Gigapixel的软件(售价100美元)来提高《最终幻想VII》的背景分辨率正是基于这类技术。

具体而言,STVSR同时学习时间插值(如何在原始帧之间合成不存在的中间视频帧)和空间超分辨率(如何从相应的参考帧及其相邻帧中重建高分辨率帧);与此同时,得益于伴随的卷积长短期记忆模型,它能够利用视频上下文和时间对齐来从聚合特征中重建帧,以此合成高分辨率慢动作视频。

研究人员使用来自Vimeo的60000多个7帧剪辑的数据集对STVSR进行了培训,并使用单独的评估语料库将数据集划分为快动作、正常动作和慢动作集,以测量各种条件下的性能。在实验中,他们发现STVSR在快动作的视频上获得了显著的改进,包括那些具有挑战性的动作视频,例如篮球运动员在球场上快速移动的视频。据外媒报道称,该AI模型具有更精确图像结构和更少模糊伪影的帧重建能力,同时又比基准模型小四倍、快至少两倍。

“通过这种单阶段设计,我们的网络可以很好地探索任务中时间插值与空间超分辨率之间的内在联系,” 预印本论文的合著者写道。“它使我们的模型能够自适应地学习,以利用有用的本地和全局时间上下文来缓解大型运动问题。大量的实验表明,我们的框架比现有AI模型更有效、效率更高,并且所建议的特征时间插值网络和可变形模型能够处理非常具有挑战性的快速运动视频。”

据外媒报道称,该项目研究人员打算在今年夏天对外公布源代码。