D1真的在神坛之上吗?

明敏 发自 凹非寺

量子位 报道 | 公众号 QbitAI

在今年特斯拉AI开放日上,D1芯片风光无限。

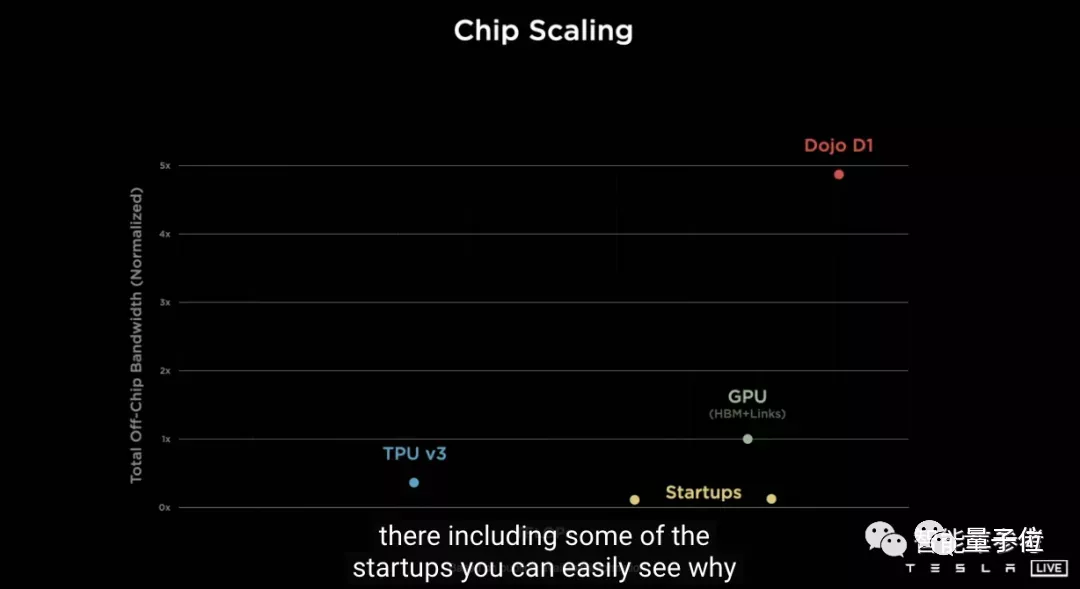

独特的晶圆封装系统+芯片设计,让D1在训练万亿参数级神经网络时,可以拥有数量级优势。

特斯拉更在发布会上表示,它在性能上已经完全碾压英伟达GPU和谷歌TPU。

不过,颠覆性的设计能够带来关注,也会遭到质疑。

最近,半导体分析网站SemiAnalysis就表示:

D1芯片存在一些重大技术问题。

内存、成本上都有疑问

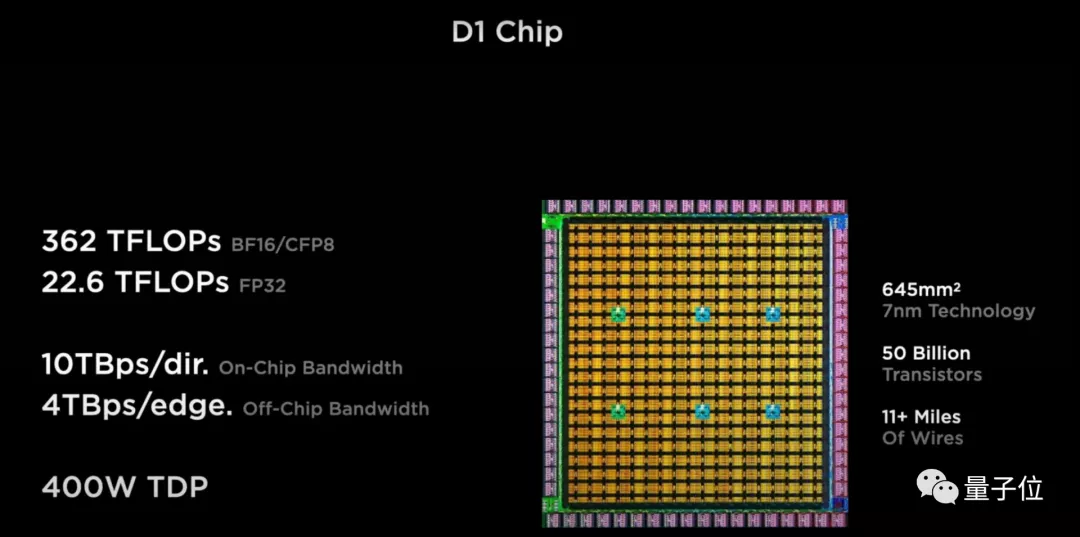

作为特斯拉首款AI训练芯片,D1芯片采用分布式结构和7nm工艺,搭载500亿个晶体管、354个训练节点,实现了超高算力和超高带宽。

根据特斯拉已经透露的信息,SemiAnalysis从以下几个方面提出了质疑:

首先是内存问题。

SemiAnalysis认为,D1芯片无论在功能单元层面还是系统层面,想要达到他们所说的算力,内存可能都不够。

功能单元层面,D1芯片的单个功能单元具有1.25MB SRAM缓存、1TFlop的FP16/CFP8精度计算能力。

在芯片层面,裸片上没有其他SRAM结构,只有354个单元的1.25MB SRAM来支撑。

基于设计相似的IPU,SemiAnalysis推测这种设计会导致严重的内存缺陷,从而影响芯片的算力。

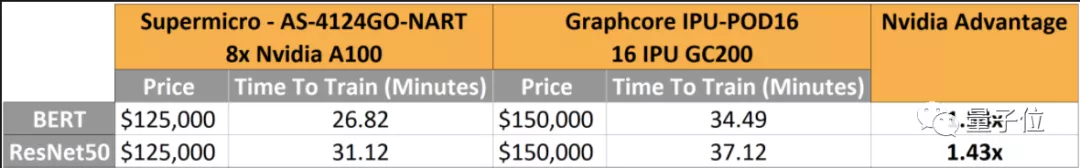

事实上,每个IPU芯片上SRAM的数量还是D1的两倍,但它在性能上和英伟达A100比起来,劣势依旧非常明显。

在BERT和ResNet50训练中,英伟达A100的速度分别是IPU的1.54倍和1.43倍。

其次,就是在成本问题上。

特斯拉D1芯片之间可以实现无缝融合,这使它能够达到8 TB/s的IO,比ASIC和英伟达高出一个数量级。

为了满足这样大的IO,特斯拉采用了独特的封装方式,即InFO_SoW。

这种封装方式的特点就是可以够大。

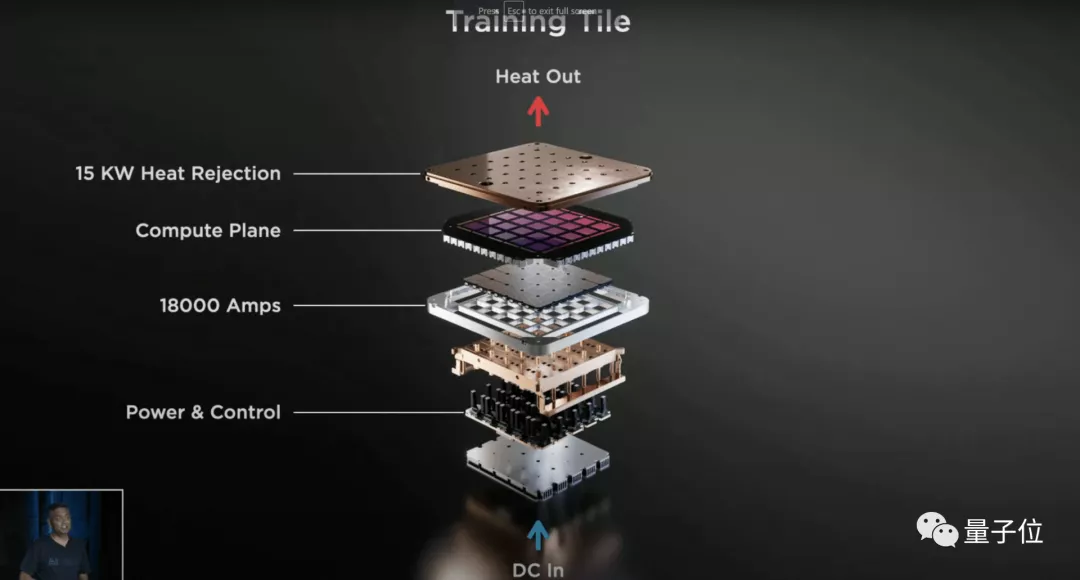

在发布会上,它们也展示了由25个D1芯片组成的训练模块。

但这种封装方式在实际生产中的难度很高,出现报废的情况会更多,由此也会导致成本突增。

除了这两方面,SemiAnalysis认为D1还有很多未解决的问题。

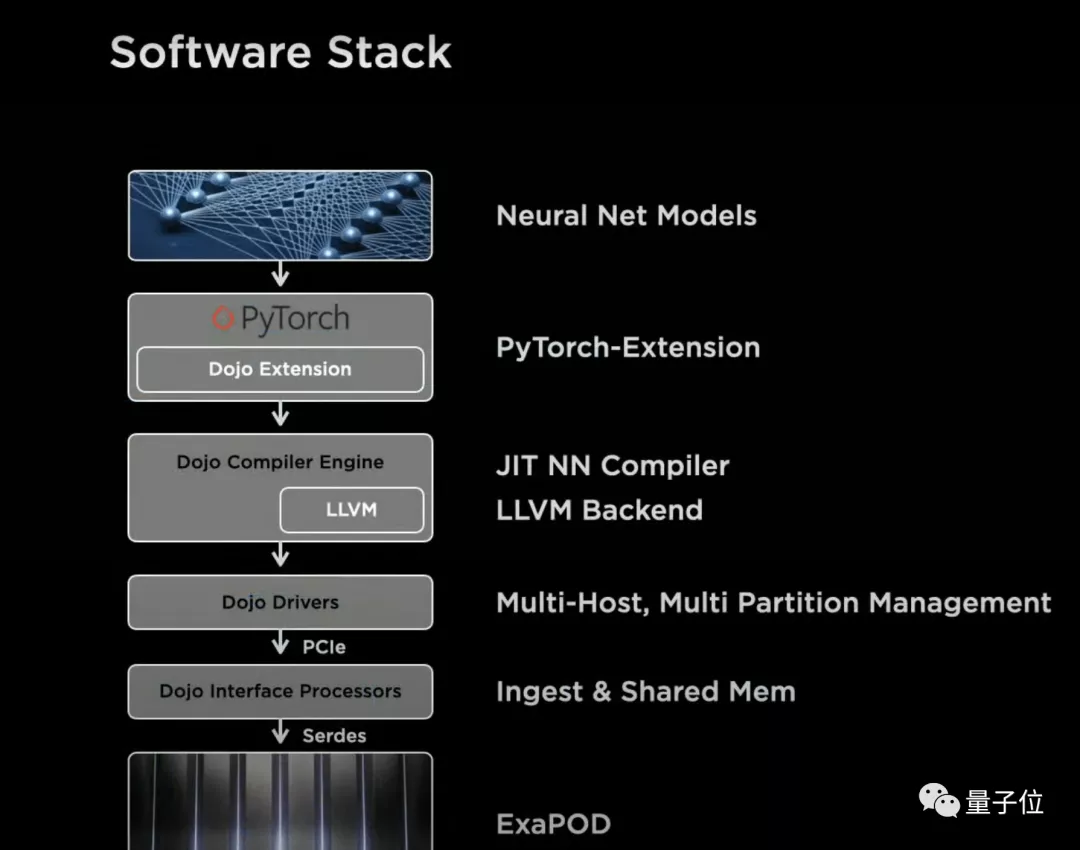

比如,在发布会现场被问到软件方面的问题时,特斯拉工程师甚至回答他们完全没有准备。

SRAM方面的问题也亟需解决,否则将会面临运行速度过快的风险。

以上种种,都导致特斯拉的开发人员需要对系统进行大量的优化。

此外特斯拉透露,目前他们已经部署的D1芯片只有3000个。

如此看来,D1芯片的摊销成本也是非常高了。

D1真的在神坛之上吗?

事实上,在特斯拉AI开放日的第二天,它的股价上涨甚至还不如英伟达。

可见投资界对于马斯克带来的新技术,也都非常冷静。

有人表示,特斯拉把技术封锁在自己的堡垒内,外界无法测评,也就无从得知它真正的优势和局限性。

这一次向特斯拉开怼的是SemiAnalysis,它是一家半导体分析评论网站,首席分析师为Dylan Patel,毕业于佐治亚大学特里商学院。

参考链接:

[1]https://semianalysis.com/the-tesla-dojo-chip-is-impressive-but-there-are-some-major-technical-issues/

[2]https://news.ycombinator.com/item?id=28361807

[3]https://www.linkedin.com/in/dylanpatelsa/